Über 50 % Bot-Traffic, zwei Drittel davon sind Bad Bots

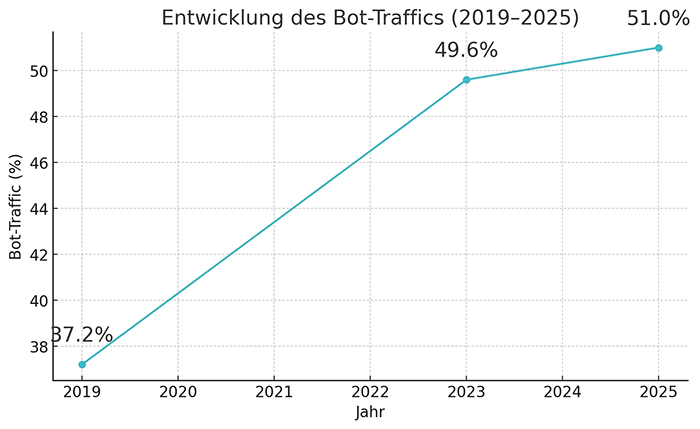

Nicht Menschen verursachen die Mehrheit des globalen Internet-Traffics, sondern Bots. Seit 2019 steigt der Anteil an Bot-Traffic kontinuierlich. Damals lag dieser noch bei 37,20 %, 2023 machte er mit 49,60 % schon fast die Hälfte des gesamten Internet-Traffics aus und heute liegen wir durchschnittlich bei etwa 51 % Bot-Traffic.

Die Erkenntnisse aus den letzten großen Bot-Traffic Studien von Imperva aus dem Jahr 2024 und von Statista aus dem Jahr 2023 sind ernüchternd. Was es noch schlimmer macht: Gut zwei Drittel des Bot-Traffics stammen von sogenannten Bad Bots. Also von Bots, deren Aufgaben darin bestehen z.B. Sicherheitslücken zu finden und auszunutzen oder Spam zu verbreiten.

In Deutschland ist der Bot-Anteil noch höher

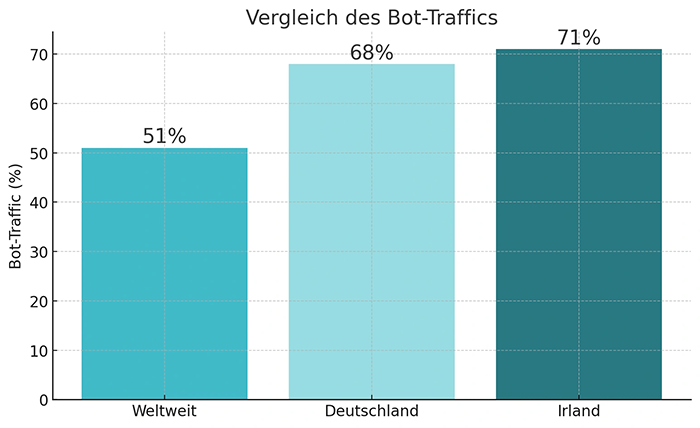

Der weltweite Anteil an Bot-Traffic von 51 % ist aber noch vergleichsweise gering zur Realität in Deutschland. Hier lag der Anteil von nicht durch Menschen verursachtem Traffic bereits 2023 bei 68 %. Spitzenreiter in Sachen Bot-Traffic ist Irland mit 71 %.

Es gibt Bot-Traffic, der für Unternehmen wichtig ist. Beispielsweise wollen wir, dass die Crawler von Google, Microsoft oder ChatGPT regelmäßig unsere Websites besuchen, damit unsere Inhalte in den Suchmaschinen gefunden werden. Aber auch diese „guten“ Bots verfälschen unsere Daten, verursachen Kosten und machen vor allem nur ein Drittel des gesamten Bot-Traffics aus.

Generative KI potenziert den Bot-Traffic

Das Aufkommen von Unmengen an KI-Tools, die allesamt eigene Crawler haben, führt zusätzlich zu einem explosionsartigen Anstieg an Bots und damit auch an Bot-Traffic. Alle Experten und Expertinnen sind sich einig, dass in den nächsten Jahren der Anteil an menschlichem Traffic weiter sinken wird.

Besonders der deutliche Anstieg von Bad Bots ist besorgniserregend. Innerhalb von nur 5 Jahren ist deren Volumen um ganze 60 % gewachsen. Bad Bots machen heute etwa 32 % des gesamten Internet-Traffics aus. Dieses Phänomen stellt Unternehmen nicht nur vor Herausforderungen bezüglich Datenqualität und Kosten, sondern auch vor zunehmende Sicherheitsprobleme.

Auswirkungen auf Datenqualität und Kosten

Bei Bot-Traffic von 68 % in DE sind die Auswirkungen auf deine Datenanalyse und auch auf deine Kosten immens. Der durch Bots verursachte Traffic hat für dich keinerlei Wert. Bots interessieren sich nicht für deine Dienstleistungen oder Produkte und werden diese auch niemals buchen oder kaufen. Im Falle von Bad Bots ist dieser Traffic nicht nur irrelevant, sondern auch noch potenziell schädlich.

All der Traffic von Bots verfälscht hochgradig deine Daten. Egal, ob Aufrufe, Klicks, Absprungraten, Sitzungsdauern, Events oder auch Conversions. Würdest du den Bot-Traffic komplett herausfiltern, würdest du auf völlig andere Zahlen blicken und die Schlüsse aus deiner Datenanalyse würden vermutlich ganz anders ausfallen.

Auch die laufenden Kosten deiner Infrastruktur steigen durch den Bot-Traffic. Schließlich sind die Preise für Servernutzung oder Webhosting-Pakete in der Regel an das Traffic-Volumen gekoppelt. Ohne den Bot-Traffic würde dein Volumen deutlich geringer ausfallen und dementsprechend würdest du mit günstigeren Paketen locker auskommen.

Bis zu 20 % deines Google Ads Budgets geht für Bots drauf

Die Bots machen vor Klicks auf Anzeigen keinen Halt. Sprich auch bei Google Ads oder (noch viel gravierender) bei Display Ads klicken Bots auf Links in Suchergebnissen oder auf Banner. Die Folge: Du zahlst für Klicks von Maschinen, die für dich überhaupt keinen Wert haben.

Daten von Cloudflare, ClickPatrol oder ClickCease bescheinigen diesem durch Bots verursachten Klickbetrug einen Klick-Anteil von bis zu 20 %. Gut ein Fünftel der von dir bezahlten Klicks stammen also nicht von Menschen.

Google versucht möglichst viele Bot-Klicks herauszufiltern, weshalb in deiner monatlichen Google Ads Abrechnung häufig Gutschriften für „ungültige Klicks“ auftauchen. Diese ungültigen Klicks wurden bis vor 1-2 Jahren auch noch als Metrik im Werbekonto ausgewiesen – heute ist das leider nicht mehr der Fall.

Conversion-Auswertung deckt den Bot-Traffic auf

Aber die Filter von Google erkennen beileibe nicht alle Bot-Klicks und das lässt sich mit einer genauen Conversion-Auswertung nachvollziehen. Gleichst du die Uhrzeiten der Klicks mit Conversions in deinem Google Ads Konto mit den tatsächlich bei dir eingegangenen Conversions ab, wirst du schnell feststellen, dass nicht wenige im Werbekonto vermeldete Conversions nie bei dir angekommen sind.

B2B mehr betroffen als B2C

Die Anzahl an Bot-Klicks auf Anzeigen ist in den Bereichen B2B und B2C mehr oder weniger identisch. Allerdings sind die Auswirkungen auf Conversion-Daten und die gesamte Kampagnenschaltung im B2B deutlich gravierender.

Bots klicken auf Anzeigen, auf Links, auf Buttons. Aber Bots nutzen keine Zahlmethode und können in Online-Shops deshalb in der Regel keinen Sale und damit keine entsprechende Conversion auslösen.

Aber im B2B-Bereich werden Conversions erfasst, wenn z.B. ein Kontaktformular abgeschickt, ein Newsletter bestellt oder auf eine Telefonnummer geklickt wird. All diese Handlungen beruhen auf Klicks, die auch Bots leicht auslösen können.

Bot-Klicks lassen Google Ads Kampagnen scheitern

Diese Bot-Klicks führen nicht nur zu unnötigen Kosten und einer Verfälschung deiner Daten, sondern können auch deine gesamte Kampagne scheitern lassen. Sagen wir deine Google Ads Gebotsstrategie ist „Conversions maximieren“. Der Algorithmus nimmt die erzielten Conversions, analysiert alle damit zusammenhängenden Daten und versucht mehr Personen zu erreichen, die ähnlich denen sind, die bereits Conversions ausgelöst haben.

Wenn aber bis zu 20 % deiner Conversions durch Bots verursacht wurden, wird das Google Ads System auch darauf optimieren, mehr solcher „Nutzer“ anzusprechen. Schließlich haben diese rein technisch Conversions ausgelöst. Ein Teufelskreis, der deine Gebotsstrategie bzw. die Kampagnenoptimierung ad absurdum führt und deine Werbung gezielt auf wertlosen Bot-Traffic ausrichtet.

Was also tun, um Bot-Traffic zu reduzieren?

Welche Maßnahmen kannst du ergreifen, um den Bot-Traffic und all seine negativen Auswirkungen möglichst einzudämmen?

- Bot-Detection

Läuft deine gesamte Datenerfassung über deinen eigenen Server (Server-Side-Tracking) oder ist diese zentral über den Google Tag Manager auf deiner Website integriert, kannst du jeweils eine Bot-Detection einrichten, die Zugriffe von bekannten Bad Bots blockiert. Das verhindert niemals den gesamten Bot-Traffic, macht aber bereits einen gehörigen Unterschied. Du solltest aber sicherstellen, dass du keine Bots blockierst, die für dich wichtig sind.

- Bot-Traffic über robots.txt reduzieren

Du kannst über deine robots.txt Datei steuern, welche Crawler bzw. Bots auf deine Website zugreifen dürfen. Dabei empfiehlt es sich, eine Whitelist und keine Blacklist zu erstellen. Blockiere besser alles und lasse Ausnahmen für relevante Bots zu, als zu versuchen alle Bad Bots auszuschließen. Denn die Liste an Bad Bots wird täglich länger und das wäre ein Kampf gegen Windmühlen.

Um sicherzugehen, dass dir das nicht auf die Füße fällt, solltest du deine Logfiles analysieren und dadurch sicherstellen, dass nach der Anpassung die erwünschten Bots auch weiterhin deine Seite besuchen. Übrigens gewährleisten die Einträge in der robots.txt Datei nicht, dass die Bots sich auch an die Anweisungen halten. Aber in aller Regel reduzierst du den negativen Bot-Traffic dadurch gewaltig.

- GA4 Filter setzen

Wenn du in deinen Google Analytics Daten besonders viele Zugriffe durch bestimmte Bots identifizierst, kannst du diese Zugriffe präventiv aus deinen Daten herausfiltern. Allerdings solltest du solche oft irreversiblen Filter nicht auf deine Haupt-Property anwenden. Erstelle besser eine weitere Property und setze die Filter nur dort – dann kannst du auch gut vergleichen, wie groß die Unterschiede mit und ohne entsprechenden Bot-Traffic sind.

- Conversion-Tracking anpassen

Die Erfassung von Conversions solltest du in jedem Fall möglichst „bot-sicher“ machen. Achte beispielsweise darauf, dass nur dann eine Conversion gemessen wird, wenn dein Kontaktformular auch wirklich versendet wurde und nicht bloß, wenn Mensch oder Maschine auf „absenden“ geklickt haben.

Nutze für alle Formulare moderne Recaptcha, die von herkömmlichen Bots nicht gelöst werden können. Verwende für die Trigger deines Conversion-Trackings eine Kombination aus Handlung und Zeit: Eine Conversion wird z.B. nur dann gemessen, wenn eine bestimmte Handlung ausgeführt wurde (Klick auf Button X) UND die Verweildauer mindestens 30 Sekunden betrug. Die Verweildauer bei Bot-Traffic ist extrem gering, weshalb Bots durch diese Konfiguration weitaus weniger Conversions auslösen können.

- Clickfraud Tools verwenden

Im Falle von Google Ads kannst du Tools wie ClickCease nutzen, die auf Klickbetrugsschutz spezialisiert sind und Anzeigen vor Bots präventiv verbergen. Die Filter solcher Tools haben diverse Einstellungsmöglichkeiten, zum Beispiel um die Anzeigenausspielung für bestimmte IP-Adressen, VPN- oder Proxy-Traffic oder Traffic aus spezifischen Ländern zu unterbinden.

Fazit: Jetzt handeln und Bot-Traffic eindämmen

Der Bot-Traffic ist groß, wird immer größer und betrifft uns alle. Datenqualität, Kosten, Erfolg von Kampagnen, Sicherheit – auf so vielen Ebenen machen sich die negativen Auswirkungen bemerkbar. Jedes Unternehmen sollte deshalb die Reduzierung von Bot-Traffic auf der Agenda haben.

Wer nicht aktiv wird, kann seinen Daten nicht mehr vertrauen, hat unnötig hohe Kosten, schaltet ineffiziente Werbekampagnen und riskiert in zunehmenden Maße die Sicherheit der eigenen Website und digitalen Infrastruktur.